大數據治理與服務 構建高效、可信的數據處理新范式

在數據已成為核心生產要素的今天,海量、多源、異構的數據洪流既帶來了前所未有的機遇,也伴生著質量參差、標準不一、安全風險等諸多挑戰。如何駕馭這龐大的數據資產,使其真正轉化為洞察力與價值?這離不開兩大關鍵支柱:大數據治理與數據處理服務。二者相輔相成,共同構成了現代企業數據能力建設的基石。

一、大數據治理:為數據價值釋放奠定基石

大數據治理并非單一的技術方案,而是一套覆蓋數據全生命周期的管理體系,旨在確保數據的可用性、一致性、完整性、安全性與合規性。其核心目標是為組織提供高質量、可信賴的數據基礎。

核心框架與實踐:

1. 戰略與組織保障:確立數據作為戰略資產的定位,建立跨部門的數據治理委員會,明確權責,制定與企業目標一致的數據戰略。

2. 元數據與數據標準管理:統一數據的“身份證”(元數據)和“語言”(數據標準),確保不同系統、部門對數據的理解一致,是實現數據整合與共享的前提。

3. 數據質量管理:通過建立數據質量規則、實施全鏈路監控、定期評估與清洗,持續提升數據的準確性、完整性和及時性,讓決策“心中有數”。

4. 數據安全與隱私保護:在數據采集、存儲、使用、共享和銷毀的全過程中,實施分級分類、訪問控制、加密脫敏、審計追蹤等措施,嚴守合規底線(如GDPR、個人信息保護法等),防范數據泄露與濫用風險。

5. 主數據管理:對客戶、產品、組織等核心業務實體(主數據)進行統一、權威的定義和維護,確保關鍵數據“單一真相源”,支撐業務流程高效協同。

有效的治理如同為數據資產建立了清晰的“地圖”和“交通規則”,是數據價值得以安全、合規、高效釋放的根本保障。

二、數據處理服務:驅動數據價值轉化的引擎

如果說治理構建了堅實的“路基”,那么數據處理服務則是其上高速運行的“車輛”。它是指利用一系列技術、工具和方法,對原始數據進行采集、清洗、整合、轉換、分析和應用,最終形成可服務于業務決策、產品創新或流程優化的信息與知識。

關鍵服務層次與技術棧:

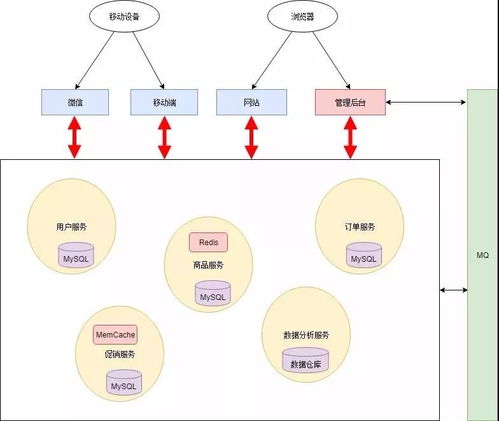

1. 數據集成與預處理服務:通過ETL/ELT、流式采集、數據同步等技術,將分散、異構的數據源匯聚到數據湖或數據倉庫中,并進行初步的清洗與格式化,為后續分析做好準備。

2. 數據存儲與計算服務:基于Hadoop、Spark、Flink等分布式框架,或云上數據倉庫(如Snowflake、BigQuery)、數據湖倉一體方案,提供海量數據的低成本存儲與高性能并行計算能力。

3. 數據分析與挖掘服務:運用SQL查詢、統計分析、機器學習、圖計算等方法,從數據中發現模式、趨勢與關聯關系,生成預測模型與業務洞察。可視化工具(如Tableau、FineBI)則讓洞察一目了然。

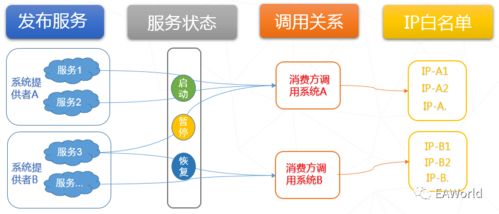

4. 數據服務化與API化:將處理后的數據或分析結果,封裝成標準、易用的數據服務接口(API),供內部業務系統、應用或合作伙伴直接調用,實現數據能力的快速交付與復用,支撐敏捷業務創新。

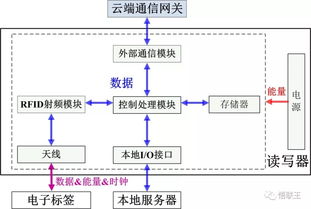

5. 實時數據處理與流式服務:針對物聯網、金融交易、在線推薦等對時效性要求極高的場景,提供實時數據攝入、流式計算與即時分析的能力,實現“秒級”甚至“毫秒級”的響應與決策。

三、治理與服務的融合:構建數據驅動型組織的閉環

大數據治理與數據處理服務絕非孤立的兩個環節,而是緊密耦合、循環促進的有機整體。

- 治理賦能服務:高質量的治理為數據處理服務提供了干凈、可信、標準化的“原材料”,大幅降低了后續數據清洗、整合與分析的復雜度和成本,提升了分析結果的可靠性與決策有效性。明確的權責與安全策略也保障了數據服務過程的安全可控。

- 服務反饋治理:數據處理服務在實踐過程中,能夠不斷暴露出數據質量、標準、安全等方面的新問題與新需求,從而反向驅動治理策略、規則與流程的持續優化與迭代。例如,一個新的分析模型可能要求更細粒度的數據質量指標。

這種“治理定規則、服務出價值、反饋優治理”的閉環,共同推動組織從“擁有數據”邁向“善用數據”,最終構建起以數據為核心競爭力的智慧型組織。

###

在數字經濟時代,大數據治理與數據處理服務是企業挖掘數據“石油”、煉制數據“燃料”不可或缺的兩大核心能力。前者是確保數據資產健康、安全、合規的“治理體系”,后者是釋放數據能量、驅動業務增長的“轉化引擎”。只有將二者系統性地結合,建立持續演進的數據運營體系,才能讓數據真正流動起來、用起來、活起來,在激烈的市場競爭中贏得先機。

如若轉載,請注明出處:http://m.hymyt.cn/product/60.html

更新時間:2026-02-18 05:48:17